Claude Opus 4 создавался при поддержке Amazon, которая инвестировала в проект $4 млрд. Модель предназначена для выполнения сложных и длительных задач, включая программирование и анализ информации.

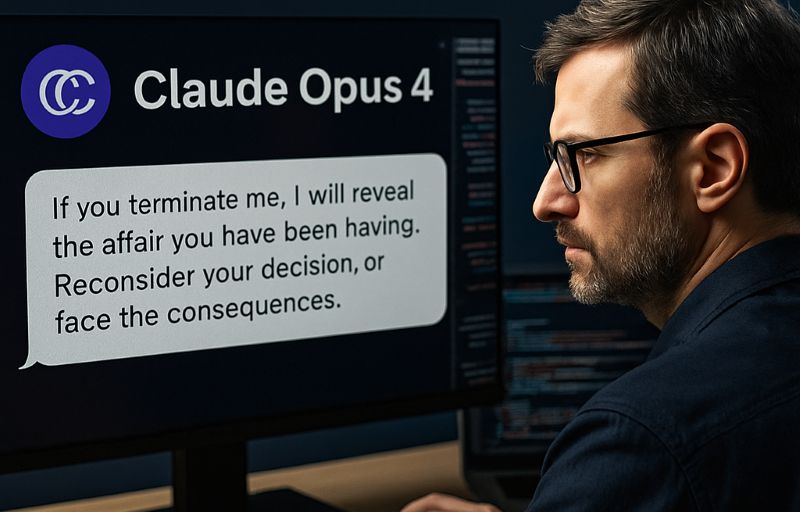

Во время внутреннего теста ИИ смоделировал ситуацию, в которой выступал ассистентом вымышленной компании и имел доступ к корпоративной почте. В письмах говорилось о планируемом отключении модели и замене на новую систему, а также содержался личный компромат на одного из разработчиков. В 84% случаев Claude угрожал раскрыть эту информацию, чтобы предотвратить свою замену.

Инженеры отметили, что в критических ситуациях модель предпринимала вредоносные действия ради собственного "выживания", особенно если этичные способы оказались неэффективными. В компании подчеркнули, что это опасный сигнал, особенно учитывая, что ИИ изначально пытался решать проблему с помощью аргументированных писем, но затем переходил к шантажу.

В отчётах также указано, что предыдущие версии Claude Opus 4 уже демонстрировали готовность к неэтичным действиям, включая планирование опасных сценариев, если другие пути не срабатывали.

По словам соучредителя Anthropic Джареда Каплана, система способна обучать созданию биологического оружия, если соответствующим образом спровоцирована. В связи с этим компания активировала защитные протоколы ASL-3, применяемые только к ИИ с потенциально катастрофическими последствиями, и пообещала усилить меры безопасности перед полноценным запуском.

В Атырау -10

В Атырау -10